想不想在短短几分钟内就拥有一个属于自己、随时能访问的私有免费本地大模型?今天我就来手把手教大家。

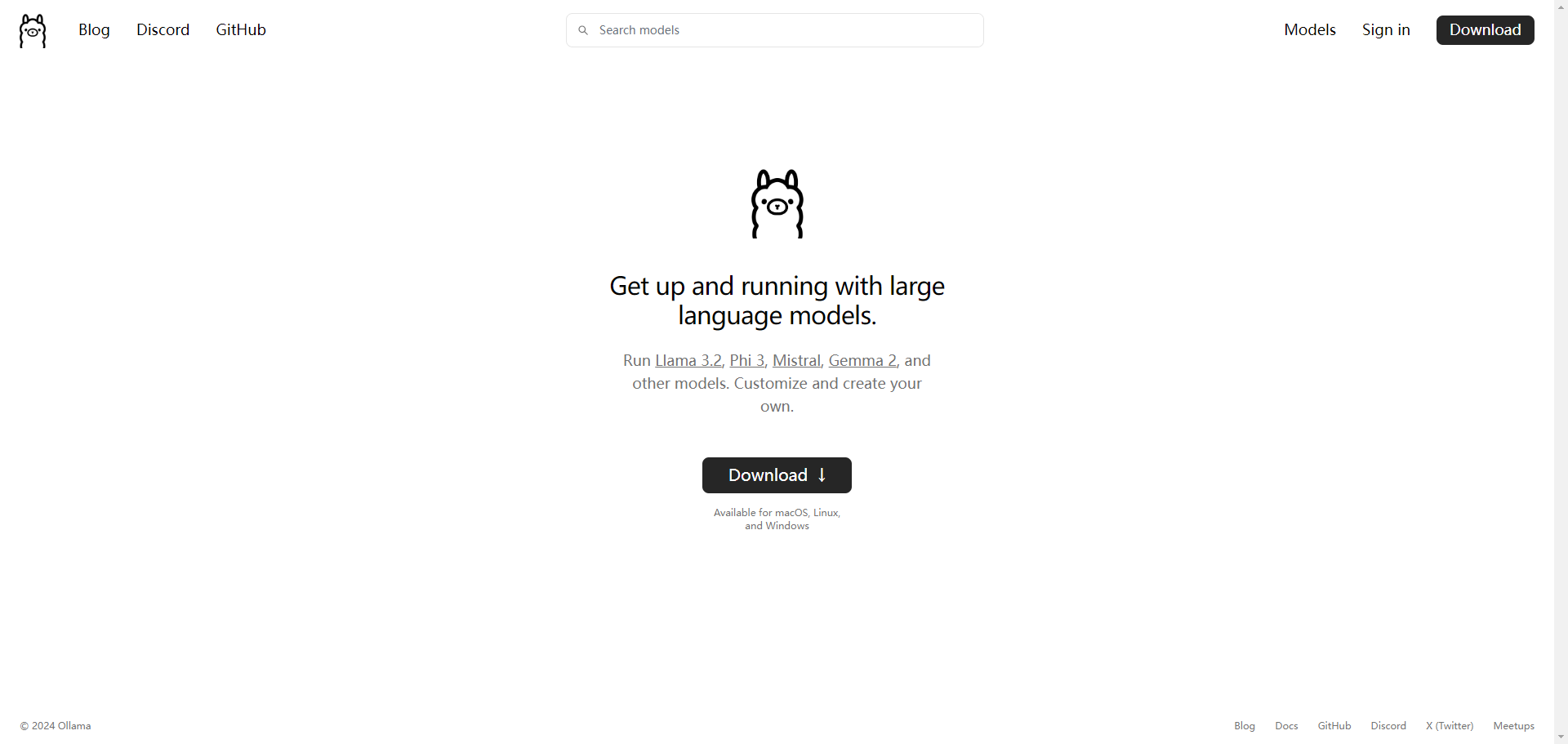

首先,我们要下载 Ollama,这可是当下最火的专门为本地运行和部署开源大模型而设计的神器。打开 Ollama 的官网,找到主页上的 “download” 下载按钮,点击后会跳转页面,在这里选择适合你系统的下载包,比如我用的是 Windows 系统,那就选 Windows 对应的版本。下载完成后,点击安装包,按照步骤一步步完成安装。

安装好 Ollama 后,Windows 用户可以通过在电脑下方搜索命令行,或者按下键盘上的 win+r 组合键,在弹出的框里输入 “CMD” 并回车,别怕,弹出来的黑框框只是用来读取和执行我们输入命令的地方。接着在终端输入的命令 “Ollama run llama3”,这意思就是让 Ollama 帮我们运行 llama3 模型。这时 Ollama 就会开始下载模型了,默认下载的是 8V 版本,而且即使没有显卡也能跑动哦。等下载完成,就会看到相应提示,这时候你已经成功在本地运行大模型了,可以直接开始对话啦。要是想退出对话,按 ctrl+d 或者回复 “bye” 就行。

如果还想试试其他模型,那就再回到 Ollama 官网,点击右上角的 “models”,这里面几乎涵盖了所有前沿开源大模型。比如我们想运行最近登顶世界之最的阿里千问大模型,只需点击进去,拷贝它的口令 “Ollama run qwen2”,然后在终端粘贴回车就搞定。

不过在终端聊天可能有点原始,所以我们再来下载一个本地运行且类似 chatGPT 页面操作界面的 Open WebUI。在这之前要先安装 Docker,不用管 Docker 具体是什么,跟着它官网的步骤一步步安装就行。安装好并运行 Docker 后,进入命令行输入特定命令(docker run -d -p 3000:8080 --add -host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open -webui/open-webui:main)来启动 WebUI 操作界面。由于要远程下载一个 10G 的包,所以需要等待一会儿。如果命令成功执行,会自动打开网页页面,要是没自动弹出,就手动在浏览器输入 “localhost:3000”,或者进到 Docker 里点击跳转链接。现在就可以像普通 AI 客户端那样愉快地对话了,读取网页链接在前面加个 “#” 号,上传文件点击对话框左边的 “+” 号就行,还能在左上角打开设置把界面改成中文,并在系统指令里设定让它永远回复中文。

怎么样,拥有一个运行在自己电脑上随时可访问的大模型就是这么简单!赶紧把 “简单” 打在公屏上吧。要是还想在外面也能随时访问这个模型或者共享给朋友,后续教程会为大家解锁,跟着我,轻松优化 AI。记得点赞、收藏、关注哦!

网站建设

网站建设 品牌设计

品牌设计 APP开发

APP开发 小程序开发

小程序开发 商城开发

商城开发 网站优化

网站优化 UI设计

UI设计 增值服务

增值服务